¿Cuántos megabytes en un gigabyte?

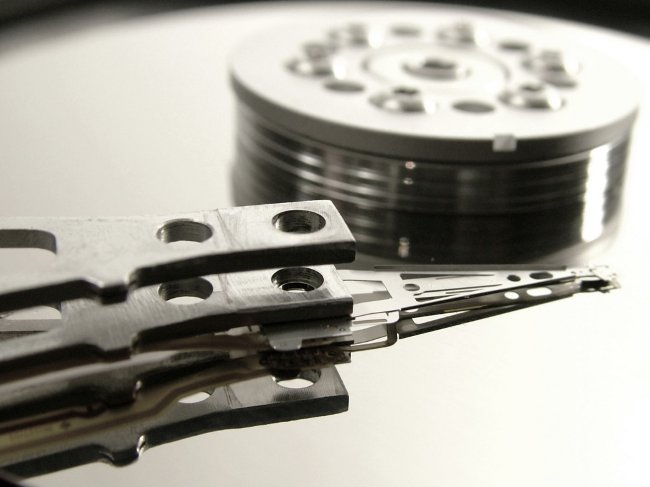

Muchos usuarios no se han encontrado demasiadouna situación agradable: compra un disco duro con un volumen, por ejemplo, 500 gigabytes, conéctelo a una computadora y descubra que hay disponibles 480 gigabytes. Y todo porque los fabricantes de discos duros creen que el gigabyte es de 1000 megabytes, y el sistema operativo Windows está seguro de que 1024. ¿Quién tiene razón? ¿Cuántos megabytes en un gigabyte?

Muchos usuarios no se han encontrado demasiadouna situación agradable: compra un disco duro con un volumen, por ejemplo, 500 gigabytes, conéctelo a una computadora y descubra que hay disponibles 480 gigabytes. Y todo porque los fabricantes de discos duros creen que el gigabyte es de 1000 megabytes, y el sistema operativo Windows está seguro de que 1024. ¿Quién tiene razón? ¿Cuántos megabytes en un gigabyte? El inconveniente principal es que La cantidad de información se puede medir en sistemas binarios y decimales. Además, existen varios estándares de unidades para medir la cantidad de información. Esto causa confusión y hace que sea difícil determinar exactamente cuántos megabytes hay en un gigabyte.

En realidad, los prefijos "kilo", "mega", "giga-", etc. se usan en el Sistema Internacional de Unidades (SI) y denotan los poderes del número diez. Por lo tanto, si piensa lógicamente, en un gigabyte debería haber 1000 megabytes. Pero, ¿por qué su sistema operativo está seguro de que hay 1024 de ellos?

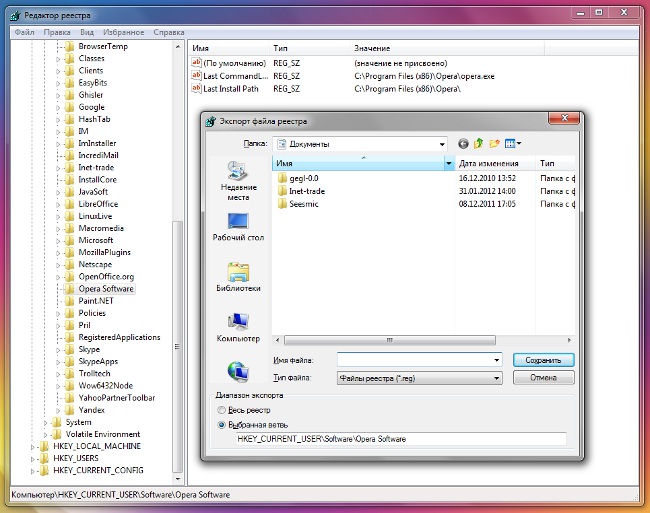

El hecho es que los desarrolladores de muchos sistemas operativos modernos usan la memoria estándar JEDEC 100B.01 (el estándar del Consejo Conjunto de Ingeniería paradispositivos electrónicos), según el cual los prefijos aceptados en el sistema SI no pueden denotar una potencia de diez, sino una potencia de dos (es decir, el estándar no utiliza un sistema de número decimal, sino uno binario). Por lo tanto, un gigabyte por el estándar JEDEC será igual a 1024 megabytes.

Y los fabricantes de discos duros y unidades flash usan Normas adoptadas por la Comisión Electrotécnica Internacional (CEI). De acuerdo con estos estándares, los prefijos SI se usan para designar grados del número diez. Por lo tanto, un gigabyte debería ser de 1000 megabytes y no más megabytes. GOST 8.417-2002, regulando los nombres de las unidades de medida en el territorio de Rusia, también se adhiere a este punto de vista.

Si es importante enfatizar que estamos hablando de un sistema de números binarios, Es necesario usar consolas no decimales, sino binarias (binarias). En este caso, 1024 bytes equivaldrán a un kibibyte, 1024 kibibytes a un mebibyte, 1024 mebibytes a un gibi-byte. Son estos archivos adjuntos binarios adoptados en el estándar IEC.

El problema es que archivos adjuntos binarios, aunque son correctos, pero prácticamente no se utilizan. Primero, históricamente, resultó queLas consolas decimales se utilizan para indicar las unidades de la cantidad de información en el sistema binario. En segundo lugar, las consolas binarias simplemente no son muy eufónicas.

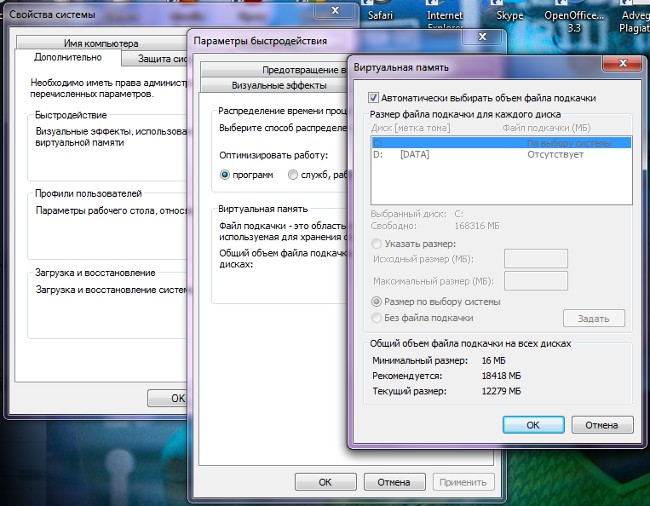

Por lo tanto, es poco probable que un usuario común se encuentreunidad de medida "gibibyte", porque casi nadie la usa. ¿Y cómo puede determinar cuántos megabytes en un gigabyte en este caso particular son 1000 o 1024? Se debe prestar atención a escribir una unidad para medir la cantidad de información.

De acuerdo con la propuesta de IEC, si se implica un kilobyte / megabyte / gigabyte binario, la notación debe comenzar con una letra mayúscula, por ejemplo, GB, Gbyte, GB. Esta designación indica que el gigabyte en este caso es 1024 megabytes. Si la primera letra de la notación es minúscula (gbyte, gbyte, gb), nos referimos a un gigabyte decimal ("comercial") que consta de 1000 megabytes.

Como puedes ver, en la designación de unidades de medida del volumen de información, prefijos SI decimales, que se usan incluso en aquellos casos en los que el estándar IEC debe usar prefijos binarios. Por lo tanto, en gigabytes resulta ser 1000, luego 1024 megabytes.

Es más fácil recordar eso los fabricantes de discos duros y unidades flash usan gigabytes "correctos", decimales. Y los fabricantes de RAM,memoria de video, CD, así como Microsoft y Apple (desarrolladores de OS Windows y Mac OS X, respectivamente) y los desarrolladores de software usan gigabytes binarios que contienen 1024 megabytes (que sería correcto llamar a gibibytes y mebibytes).